ПОЗНАВАТЕЛЬНОЕ Сила воли ведет к действию, а позитивные действия формируют позитивное отношение

Как определить диапазон голоса - ваш вокал

Игровые автоматы с быстрым выводом

Как цель узнает о ваших желаниях прежде, чем вы начнете действовать. Как компании прогнозируют привычки и манипулируют ими

Целительная привычка

Как самому избавиться от обидчивости

Противоречивые взгляды на качества, присущие мужчинам

Тренинг уверенности в себе

Вкуснейший "Салат из свеклы с чесноком"

Натюрморт и его изобразительные возможности

Применение, как принимать мумие? Мумие для волос, лица, при переломах, при кровотечении и т.д.

Как научиться брать на себя ответственность

Зачем нужны границы в отношениях с детьми?

Световозвращающие элементы на детской одежде

Как победить свой возраст? Восемь уникальных способов, которые помогут достичь долголетия

Как слышать голос Бога

Классификация ожирения по ИМТ (ВОЗ)

Глава 3. Завет мужчины с женщиной

Оси и плоскости тела человека - Тело человека состоит из определенных топографических частей и участков, в которых расположены органы, мышцы, сосуды, нервы и т.д.

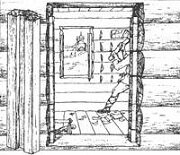

Отёска стен и прирубка косяков - Когда на доме не достаёт окон и дверей, красивое высокое крыльцо ещё только в воображении, приходится подниматься с улицы в дом по трапу. Отёска стен и прирубка косяков - Когда на доме не достаёт окон и дверей, красивое высокое крыльцо ещё только в воображении, приходится подниматься с улицы в дом по трапу.

Дифференциальные уравнения второго порядка (модель рынка с прогнозируемыми ценами) - В простых моделях рынка спрос и предложение обычно полагают зависящими только от текущей цены на товар. Дифференциальные уравнения второго порядка (модель рынка с прогнозируемыми ценами) - В простых моделях рынка спрос и предложение обычно полагают зависящими только от текущей цены на товар.

| Решение задачи многомерной оптимизации аналитическим методом

Необходимые условия существования точки экстремума:   откуда откуда   . .

Начальная точка итерационного процесса численного решения задачи многомерной оптимизации Выбрать начальную точку -  . . Решение задачи численной оптимизации методами наискорейшего спуска, градиентного спуска с дроблением шага «ручным расчетом» Из 6.8.3-3 в [2] имеем:  где где

Построим функцию  , ,

Из условия  определим параметр определим параметр  : :  , k=0, 1,… , k=0, 1,…

Произведем вычисления, а результаты представим в табл. 6.8-2: | k | x | y |  |  |  |  | | | 0.5 | 0.2097 | | | 27.75 | | 0.5806 | -0.1290 | 0.3095 | 1.1613 | -0.7742 | 26.3871 | | 0.2212 | +0.1105 | 0.2097 | 0.4424 | 0.66359 | 26.0857 | | 0.1284 | -0.0285 | 0.3095 | 0.2569 | -0.171 | 26.0189 | Xmin = 0.1284, ymin = -0.0285, f = 26.0189. Погрешности после трех итераций Вычислить погрешности после трех итераций:

Схема алгоритма, программа и результаты контрольного тестирования Схемы алгоритмов оптимизации методами НСА и ГДШ приведены на рис. 6.8.4-2 и

рис. 6.8.3-2 в [2]. Программы студенты должны составить самостоятельно. Решение задачи оптимизации на ПК Получить решение на ПК по составленным программам с точностью Е=0.1; 0.05; 0.01; 0.001. Результаты решения задачи оптимизации градиентным методом с дроблением шага (ГДШ) при точности вычисления минимума E=0.1; 0.05; 0.01; 0.001представлены в

табл. 6.8-3. | k | E | X | y |  |  |  |  | | 0.1 | 1.0000 | 0.5000 | 27.75 | 0.0000 | 2.0000 | 3.0000 | | 0.2000 | -0.7000 | 27.5100 | 0.4000 | 0.4000 | -4.2000 | | 0.1200 | 0.1400 | 26.0732 | 0.2000 | 0.2400 | 0.8400 | | 0.0720 | -0.0280 | 26.0075 | 0.2000 | 0.1440 | -0.1680 | | 0.0144 | 0.0392 | 26.0048 | 0.4000 | 0.0288 | 0.2352 | | 0.0086 | -0.0078 | 26.000 | | | | | 0.05 | 1.0000 | 0.5000 | 27.75 | 0.0000 | 2.0000 | 3.0000 | | 0.2000 | -0.7000 | 27.5100 | 0.4000 | 0.4000 | -4.2000 | | 0.1200 | 0.1400 | 26.0732 | 0.2000 | 0.2400 | 0.8400 | | 0.0720 | -0.0280 | 26.0075 | 0.2000 | 0.1440 | -0.1680 | | 0.0144 | 0.0392 | 26.0048 | 0.4000 | 0.0288 | 0.2352 | | 0.0086 | -0.0078 | 26.000 | | | | | 0.01 | 1.0000 | 0.5000 | 27.75 | 0.0000 | 2.0000 | 3.0000 | | 0.2000 | -0.7000 | 27.5100 | 0.4000 | 0.4000 | -4.2000 | | 0.1200 | 0.1400 | 26.0732 | 0.2000 | 0.2400 | 0.8400 | | 0.0720 | -0.0280 | 26.0075 | 0.2000 | 0.1440 | -0.1680 | | 0.0144 | 0.0392 | 26.0048 | 0.4000 | 0.0288 | 0.2352 | | 0.0086 | -0.0078 | 26.0002 | 0.2000 | 0.0172 | -0.0470 | | 0.0051 | 0.0015 | 26.0000 | 0.2000 | 0.0103 | 0.0094 | | 0.0010 | -0.0021 | 26.0000 | 0.4000 | 0.0020 | -0.0131 | | 0.0006 | 0.0004 | 26.0000 | | | | | 0.001 | 1.0000 | 0.5000 | 27.75 | 0.0000 | 2.0000 | 3.0000 | | 0.2000 | -0.7000 | 27.5100 | 0.4000 | 0.4000 | -4.2000 | | 0.1200 | 0.1400 | 26.0732 | 0.2000 | 0.2400 | 0.8400 | | 0.0720 | -0.0280 | 26.0075 | 0.2000 | 0.1440 | -0.1680 | | 0.0144 | 0.0392 | 26.0048 | 0.4000 | 0.0288 | 0.2352 | | 0.0086 | -0.0078 | 26.0002 | 0.2000 | 0.0172 | -0.0470 | | 0.0051 | 0.0015 | 26.0000 | 0.2000 | 0.0103 | 0.0094 | | 0.0010 | -0.0021 | 26.0000 | 0.4000 | 0.0020 | -0.0131 | | 0.0006 | 0.0004 | 26.0000 | 0.2000 | 0.0012 | 0.0026 | | 0.0003 | -0.0000 | 26.0000 | | | | Результаты решения задачи оптимизации градиентным методом наискорейшего спуска (НСА) свести в табл. 6.8-3: | K | E | x | y |  |  |  |  | | 0.1 | 1.0000 | 0.5000 | 0.0000 | 0.2096 | 2.0000 | 3.0000 | | 0.5806 | -0.1290 | 26.3870 | 0.3095 | 1.1612 | -0.7741 | | 0.2211 | 0.1105 | 26.0856 | 0.2096 | 0.4423 | 0.6635 | | 0.1284 | -0.0285 | 26.0189 | 0.3095 | 0.2568 | -0.1712 | | 0.0489 | 0.0244 | 26.0041 | 0.2096 | 0.0978 | 0.1467 | | 0.0284 | -0.0063 | 26.0009 | | | | | 0.05 | 1.0000 | 0.5000 | 0.0000 | 0.2096 | 2.0000 | 3.0000 | | 0.5806 | -0.1290 | 26.3870 | 0.3095 | 1.1612 | -0.7741 | | 0.2211 | 0.1105 | 26.0856 | 0.2096 | 0.4423 | 0.6635 | | 0.1284 | -0.0285 | 26.0189 | 0.3095 | 0.2568 | -0.1712 | | 0.0489 | 0.0244 | 26.0041 | 0.2096 | 0.0978 | 0.1467 | | 0.0284 | -0.0063 | 26.0009 | 0.3095 | 0.0568 | -0.0378 | | 0.0108 | 0.0054 | 26.0002 | | | | | 0.01 | 1.0000 | 0.5000 | 0.0000 | 0.2096 | 2.0000 | 3.0000 | | 0.5806 | -0.1290 | 26.3870 | 0.3095 | 1.1612 | -0.7741 | | 0.2211 | 0.1105 | 26.0856 | 0.2096 | 0.4423 | 0.6635 | | 0.1284 | -0.0285 | 26.0189 | 0.3095 | 0.2568 | -0.1712 | | 0.0489 | 0.0244 | 26.0041 | 0.2096 | 0.0978 | 0.1467 | | 0.0284 | -0.0063 | 26.0009 | 0.3095 | 0.0568 | -0.0378 | | 0.0108 | 0.0054 | 26.0002 | 0.2096 | 0.0216 | 0.0324 | | 0.0062 | -0.0013 | 26.0000 | 0.3095 | 0.0125 | -0.0083 | | 0.0023 | 0.0011 | 26.0000 | | | | | 0.001 | 1.0000 | 0.5000 | 0.0000 | 0.2096 | 2.0000 | 3.0000 | | 0.5806 | -0.1290 | 26.3870 | 0.3095 | 1.1612 | -0.7741 | | 0.2211 | 0.1105 | 26.0856 | 0.2096 | 0.4423 | 0.6635 | | 0.1284 | -0.0285 | 26.0189 | 0.3095 | 0.2568 | -0.1712 | | 0.0489 | 0.0244 | 26.0041 | 0.2096 | 0.0978 | 0.1467 | | 0.0284 | -0.0063 | 26.0009 | 0.3095 | 0.0568 | -0.0378 | | 0.0108 | 0.0054 | 26.0002 | 0.2096 | 0.0216 | 0.0324 | | 0.0062 | -0.0013 | 26.0000 | 0.3095 | 0.0125 | -0.0083 | | 0.0023 | 0.0011 | 26.0000 | 0.2096 | 0.0047 | 0.0071 | | 0.0013 | -0.0003 | 26.0000 | 0.3095 | 0.0027 | -0.0018 | | 0.0005 | 0.0002 | 26.0000 | 0.2096 | 0.0010 | 0.0015 | | | 0.0003 | -0.0000 | 26.0000 | | | | Координаты точки минимума и значения функции, вычисленные с точностью Е: | Метод | E | k | x | y | f(x,y) | | ГДШ | 0.1 | | 0.008640 | -0.007840 | 26.000260 | | 0.05 | | 0.008640 | -0.007840 | 26.000260 | | 0.01 | | 0.000622 | 0.000439 | 26.000000 | | 0.001 | | 0.000373 | -0.000087 | 26.000000 | | НСА | 0.1 | | 0.028411 | -0.006313 | 26.000930 | | 0.05 | | 0.010823 | 0.005412 | 26.000200 | | 0.01 | | 0.002394 | 0.001197 | 26.000010 | | 0.001 | | 0.000308 | -0.000068 | 26.000000 | Траектория поиска минимума. Построим траекторию поиска минимума:

Решение задачи оптимизации с помощью математических пакетов При использовании пакета Mathcad для минимума функции двух переменных используется функция minerr(x). Функция требует задания начальных условий для поиска (x и y) и описания целевой функции. После задания начала вычислительного блока (Given) требуется задать условия минимизации. Для решения задачи оптимизации функций нескольких переменных в MatLab используются x = fminsearch(fun, x0) ,где fun – целевая функция, а x0 – вектор начальных условий. | x0=[1; 0.5]; [x, f, e_flag, inform] = fminsearch('x(1)^2+3*x(2)^2+26', x0) x = 1.0e-004 * 0.1851 -0.3507 f = 26.0000 inform = iterations: 41 funcCount: 77 |

6.8.6. Контрольные вопросы по теме Многомерная оптимизация - На какие задачи делится задача оптимизации в зависимости от количества

параметров целевой функции? - Какая функция называется целевой функцией?

- Как называется задача оптимизации, если на значения параметров оптимизации существуют ограничения?

- Что такое градиент?

- Куда направлен антиградиент?

- Чему равен модуль антиградиента в точке минимума?

- Что такое линия уровня?

- Что такое траектория спуска?

- Что является условием окончания итерационного процесса по отысканию точки минимума в методах спуска?

- Что является условием существования минимума для функции от двух переменных?

- Как выбирается начальная точка при решении задачи многомерной оптимизации?

- Для минимизации каких функций применяются методы спуска?

- С каким направлением в градиентных методах совпадает движение к точке минимума?

- Что является достаточным условием существования минимума функции нескольких переменных?

- Какая точка называется точкой стационарности

? ? - Что показывает модуль градиента?

- Во сколько раз уменьшается шаг на каждой итерации в градиентном методе с дроблением шага (ГДШ)?

- Исходя из каких условий выбирается шаг на каждой итерации в методе наискорейшего спуска (НС)?

- Какое значение в методе ГДШ принимается за начальное значение шага

? ? - Из какого условия выбирается величина шага спуска в аналитическом методе наискорейшего спуска?

- Как осуществляется поиск очередной точки траектории спуска в методе наискорейшего спуска?

- Что нужно сделать, чтобы повысить точность определения точки минимума в методах многомерной оптимизации?

- Что нужно сделать, чтобы с использованием метода наискорейшего спуска найти максимум функции f(x1, x2)?

- Какой метод позволяет избежать «овражного» эффекта?

- Для чего используется метод одномерной оптимизации в численном методе наискорейшего спуска (НСЧ)?

- Как называется множество точек, для которых целевая функция принимает постоянное значение

? ? - Как называется вектор первых частных производных целевой функции?

- Относится ли к методам многомерной оптимизации правило Рунге?

- В методах многомерной оптимизации существует ли группа методов, в которых точка минимума (максимума) функции находится путем вложенных отрезков?

- Относится ли к методам многомерной оптимизации метод наискорейшего спуска?

|

откуда

откуда

.

. .

. где

где

,

,

определим параметр

определим параметр  :

: , k=0, 1,…

, k=0, 1,…

?

? ?

? ?

?